Qui sommes nous

Entreprise de

services du numérique

Rintio est une entreprise de services du numérique. Nous sommes spécialisées dans le développement et l’intégration de solutions informatiques, le traitement de données, les technologies Big Data et l’Intelligence Artificielle. Nous proposons, entre autres, des prestations en Offshoring (Coding, Admin Infrastructure & Cloud, DevOps) pour nos clients en Europe et dans le monde.

Offshoring

Concentrez vous sur votre cœur d’activité.

• Dev. Python Java Php

• Admin. cloud & Infra

• Admin. cloud & Infra

• Migration Cloud

• DevOps

• DevOps

Offshoring Dev

#Python #Java #Php #Javascript.

Offshoring Cloud

Administration Cloud et Infrastructure

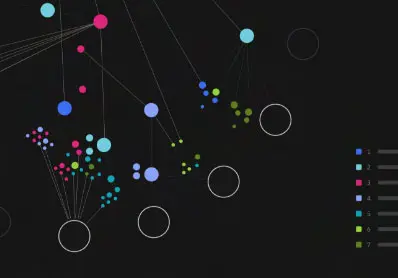

Rintio story

Vivez notre parcours dans l'écosystème technologique à travers nos actions.

Nos publications

Rintio blog

Articles à la une

Nos implantations

Notre présence dans le monde.